AIを説明可能・解釈可能とするXAI技術

XAI(説明可能なAI)とは

XAI(エックスエーアイ:Explainable Artificial Intelligence)は、日本語では「説明可能なAI」と呼ばれ、従来のAI(Artificial Intelligence)が苦手としていた「どうしてこの予測結果を導き出したのか?」という結果に至ったプロセスを説明可能にする技術や研究分野のことを指します。一般的にAI/機械学習によって作成されるAIモデルのプロセスや推論結果は、基本的に解釈が難しく、俗に「ブラックボックス(=内部がどうなっているか不明である状態)」と呼ばれています。AIモデルを世の中で実利用する段階になると、「結果に至ったプロセス・根拠が説明できないものは安心して使えない」という懸念をAI導入部門やお客様から頂くケースが増加しています。例えば、病気診断や車の自動運転でAIを活用する場合、AIがブラックボックスだとユーザへの診断結果の説明や交通事故が起こった際の原因追究ができないという問題が発生します。これらの背景から社会的にもAIに対する信頼性のニーズは高まってきており、近年ではXAIを活用・提供しようとする企業や研究が爆発的に増加しています。

要素技術

XAIには様々な手法が存在し、数値・画像・言語等のデータ形式やAIモデル・データをはじめとした説明対象、アルゴリズムによってXAI手法の選定が必要です。現在、世の中で活用されている主なXAI手法として、SHAPやGrad-CAM、Influenceといった手法が存在します。

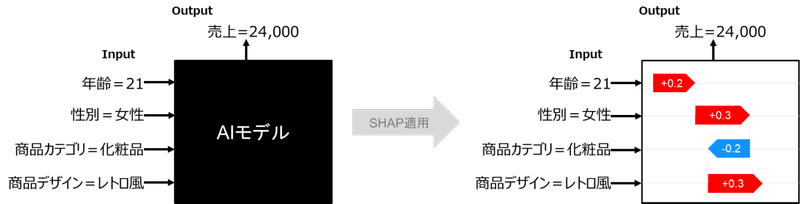

SHAP

SHAP(シャプ:SHapley Additive exPlanations)は、協力ゲーム理論のシャープレイ値に基づきモデルの予測を説明する手法です。各入力データを摂動(乱数等を用いた近傍値の作成)させたときの推論結果の変化度合いから特徴量の寄与度を算出し、推論結果に対してプラス方向に寄与する特徴量とマイナス方向に寄与する特徴量を出力することで説明します。例えば製品売上を予測させるAIに対して、年齢・性別・商品デザイン等のどの特徴量が売上に貢献しているかをSHAPによって把握し、次回の施策検討に活用することが可能です。

Grad-CAM

Grad-CAM(グラッドカム:Gradient-weighted Class Activation Mapping)は、画像に対する予測結果に対して、CNN(畳み込みニューラルネットワーク)の勾配が大きいピクセルを重要な部分と判断し可視化する手法です。例えば犬と猫を判別した際に、犬と判断するのにどこが重要であったかを可視化することで、モデルの学習がうまくできているかの確認や誤検知時の原因分析といった活用が期待できます。

Influence

Influence(インフルエンス)は、データの予測結果に対して、個々の学習データが予測に与えた影響度合いを算出する手法です。これにより、予測結果に対する精度を下げるような学習データの特定や、モデルの精度を上げる追加データの検討に活用が期待できます。

XAI技術への期待と課題

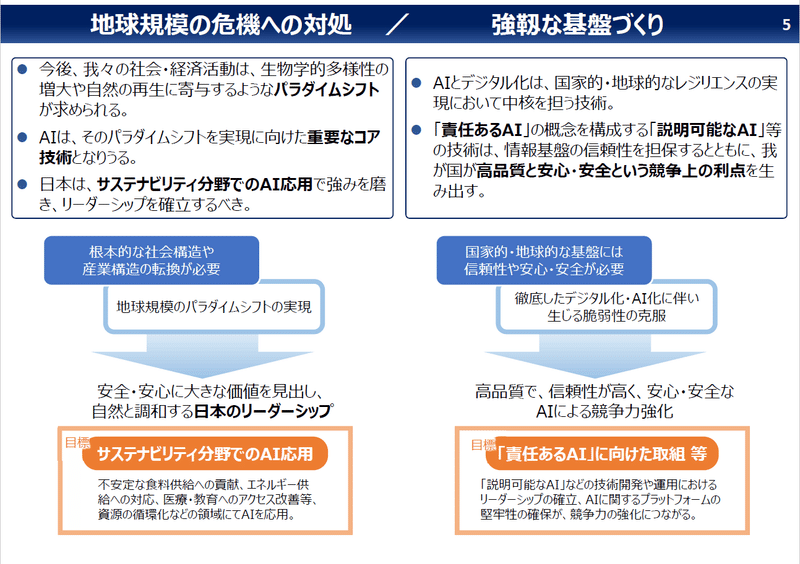

(1)社会動向

内閣府「AI戦略2022の概要」においては、「責任あるAI」の概念を構成する「説明可能なAI」等の技術は、情報基盤の信頼性を担保するとともに、我が国が高品質と安心・安全な競争利点を生み出すと位置づけされます。特に日本では高品質を要求する傾向のため、XAI技術を用いたAIの透明性や説明性の確保が期待されています。

(2)XAIを活用した未来

XAIは、将来的にあらゆるユーザや、あらゆる場面に対する説明・可視化手法が開発され、多様な分野での活用が期待できます。以下はXAI技術が普及した世界で実現する未来像の一部です。

ヘルスケア分野

ヘルスケア分野へのXAIの活用として、まずは医者であれば理解可能なレベルでの説明を目指していますが、そのレベルを達成した先として、専門的な知識のない患者の方でも理解が可能な説明を実現していきます。これにより完全無人の診療所・病院を安心して利用できる未来社会が見えてきます。

自動運転分野

自動運転車が普及するにつれ、自動運転AIの意思決定プロセスの明確化が求められます。XAIを活用することで、自動運転車がどのような判断根拠に基づいて運転しているか説明可能になるため、事故原因の解明や責任の所在が明確化されることが期待されます。

生成AI

近年Stable DiffusionやGPT等の出現によって発展が著しい生成AIでは、生成された画像やテキストに嘘が紛れていたり、学習データ・生成データの著作権問題が課題として挙げられます。生成AIにXAIを用いることで、生成結果がどの学習データを参照しているかを提示したり、生成された情報に対して信頼度を算出する等の技術が発展していき、信頼性のある生成AIの実現に貢献していくことが期待されます。

(3)XAIの課題

XAI技術の課題は、AIを活用する様々なユーザ(専門家,一般利用者、モデル開発者、監査機関、経営者等)の立場に対して、XAIの説明が必ずしも納得できるものでない場合があり、AI活用の場面に応じた納得感のある説明・可視化方法が求められています。また、AIを適用するデータ・タスクによって様々なXAI手法が存在するため、どの説明法が良いのか、そもそも説明は信頼できるのか、といった基本的な問いに対する評価方法の確立が期待されています。トッパンとしては自社の事業領域におけるXAI手法の選定・実装と並行して可視化・考察までの一連の適用プロセス確立を目指して取り組んでいきます。

トッパンの取り組み

トッパンでは、DX事業の中で主にマーケティング・BPO・製造領域でXAIの活用に取り組んでいます。例えば、予測AIシステムでのお客様への根拠説明・マーケティング施策立案、コールセンターの問い合わせ内容に対するインサイトの発見、製品画像の不良検知AIに対する原因分析等の取り組みを実施することで、DX事業のAI活用のスピード・品質向上を実現しています。

トッパン有識者コメント

DXデザイン事業部 技術戦略センター

企画・開発本部 AI技術戦略室 課長

AI技術の進展に伴い、人命や経営をはじめとした重要な意思決定にまで活用範囲のニーズが広がっていくと想定されてます。ニーズが広がる中で、安心・安全である高品質なAIモデルの提供ニーズも増大しており、競争利点を生み出すひとつの要素と位置付けられてます。

我々は、XAI技術はAIと人間が共存していく「人間中心のAI」や「責任あるAI」を実現する上で必要不可欠な技術と考えています。

AIを活用した様々なDX事業に適用可能なXAI技術の特性を活かして、当社のマーケティング、BPO、製造、セキュリティをはじめとしたあらゆる分野での活用を目指して研究・開発に取り組んでいます。

XAI技術を研究・開発していくことで世の中のAI活用を促進し、暮らしやすく、持続可能な社会の実現に貢献して参ります。

■編集者

DXデザイン事業部 技術戦略センター

企画・開発本部 AI技術戦略室